Video Games Blog

Peter Harvey

Artículo Original: https://www.unixodbc.org/doc/UserManual/

Bienvenido al Manual de Usuario de unixODBC. Este manual está dirigido a personas que utilizarán unixODBC para acceder a fuentes de datos desde herramientas y aplicaciones desarrolladas por terceros. Este manual complementa el Manual del Administrador y el Manual del Programador, cada uno de los cuales está dirigido a un público más técnico.

Primeros pasos

En este punto, unixODBC ha sido instalado por el administrador del sistema. El administrador del sistema debe haber instalado y registrado al menos un controlador ODBC. Para ello, siga las instrucciones del Manual del administrador.

Necesitará una cuenta en la máquina UNIX/Linux, que también le proporcionará su administrador del sistema. De hecho, si tiene problemas en algún punto de este manual, debería consultar a su Administrador de Sistemas para asegurarse de que todo el software necesario está instalado, las cuentas asignadas y los privilegios concedidos. También es posible que desee hablar con su Administrador de Base de Datos (DBA) para asegurarse de que tiene acceso a su base de datos y para resolver cualquier duda sobre qué controlador utilizar y qué opciones configurar.

A los usuarios de UNIX se les puede dar una amplia variedad de métodos para acceder a los recursos de su cuenta y estos métodos de acceso normalmente caen en una de dos categorías.

- cuenta shell (sesiones telnet y terminal)

- escritorio gráfico

Si se limita a una cuenta shell, no podrá utilizar las herramientas ODBCConfig y DataManager.

Ya estamos listos para empezar a utilizar las herramientas unixODBC. Lo primero que debes hacer es verificar que tienes un DNS de Sistema funcionando. Si no lo tiene; entonces debe crear un DNS de Usuario. Estas tareas se pueden realizar utilizando la herramienta ODBCConfig.

Uso de ODBCConfig

La herramienta ODBCConfig está diseñada para permitirte configurar fácilmente una Fuente de Datos (DSN). Los DSN actúan como un punto de acceso para llegar a tus datos. En muchos casos, crear un DSN es tan sencillo como elegir un controlador, seleccionar un servidor e introducir un nombre para el DSN. De hecho, DSN significa Nombre de Fuente de Datos.

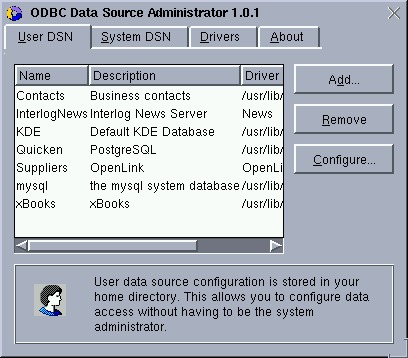

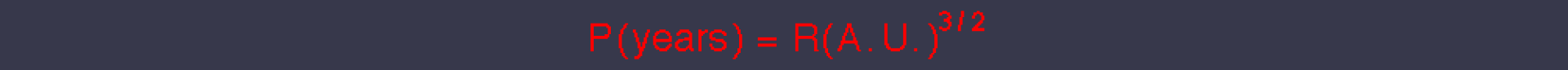

El uso de la herramienta ODBCConfig le resultará bastante intuitivo gracias a su sencilla interfaz gráfica de usuario (véase la Imagen 1), pero debe comprender algunos términos antes de empezar.

Imagen 1

DSN de usuario

Estas son sus fuentes de datos personales. Puede añadir nuevas, eliminar y/o configurar las existentes. La información del DSN de usuario se almacena en una ubicación secreta a la que sólo usted puede acceder. Mantener sus DSN de usuario separados de otros DSN le permite una gran flexibilidad y control sobre la creación y el trabajo con fuentes de datos que sólo son importantes para usted.

DSN de Sistema

Son creados por el Administrador del Sistema. Actúan de forma muy parecida a los DSN de usuario, pero con tres diferencias importantes.

- SÓLO el Administrador del Sistema puede; Añadir, Eliminar y Configurar DSN's del Sistema.

- Los DSN de sistema sólo se utilizarán si el DSN no existe como DSN de usuario. En otras palabras; su DSN de Usuario tiene precedencia sobre el DSN de Sistema.

- Todos comparten la misma lista de DSN de sistema.

Drivers

Los Drivers contienen el código especial necesario para comunicarse con el tipo específico de base de datos con el que se va a trabajar. Suelen proceder del proveedor de la base de datos, pero también pueden encontrarse en el paquete unixODBC. El administrador del sistema es el único usuario que puede instalar y registrar un driver. Usted seleccionará el Driver a utilizar cuando añada un nuevo DSN.

Añadir un DSN

Querrá asegurarse de que tiene al menos un DSN funcionando. Aquí tiene una guía rápida paso a paso para crear su primer DSN de usuario. No lo usaremos todavía porque eso implicará usar otras herramientas y aún no hemos hablado de ellas.

1. Ejecutar ODBCConfig

Esto puede hacerse de varias maneras. Si sabes que tienes un icono o un elemento de menú para ODBCConfig en tu escritorio, ejecútalo utilizando uno de estos métodos. Si no lo tiene, inicie un shell e introduzca el comando ODBCConfig. Debería aparecer una ventana emergente (ver Imagen 1).

2. Añada

Haga clic en la pestaña DSN de usuario para asegurarse de que está trabajando con DSN de usuario. Haga clic en el botón Añadir. Seleccione un driver de la lista. Si la lista está vacía, póngase en contacto con el administrador del sistema; sólo el administrador del sistema puede añadir controladores. En este ejemplo intentaremos utilizar el Controlador de Archivos de Texto. Seleccione el Driver de Archivo de Texto si lo tiene disponible.

3. Editar Opciones

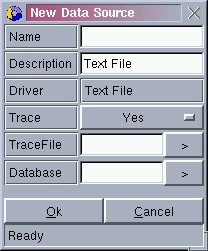

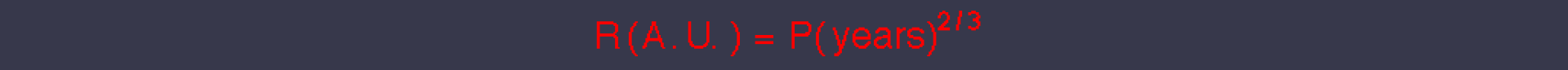

Aparecerá una lista de opciones DSN que puede editar. La Imagen 2 muestra las opciones para el controlador de archivos de texto, pero es posible que tenga un conjunto diferente de opciones si ha seleccionado un controlador distinto. Las opciones comunes son: Nombre (debe introducirse un nombre único). Descripción, Trace y TraceFile.

Imagen 2

Introduzca un nombre único, escriba un comentario, desactive Trace y haga clic en Ok para guardarlo. Puede hacer clic en Configurar, en la ventana principal, para volver a estas opciones en cualquier momento en el futuro.

4. Ya ha terminado

Observa que ahora tienes tu nuevo DSN listado en el formulario principal. Esto significa que puede intentar utilizarlo en cualquier herramienta o aplicación que utilice DSNs ODBC para el acceso a datos. Esto incluye muchas aplicaciones como procesadores de texto y hojas de cálculo. Puede probar su DSN utilizando el DataManager.

Resumen

ODBCConfig es una herramienta útil para PowerUsers pero es lo suficientemente simple para que casi cualquier usuario pueda usarla. ODBCConfig expone la razón más importante para usar ODBC para acceder a sus datos; la habilidad para usted o su Administrador de Sistemas de cambiar la Fuente de Datos para sus herramientas y aplicaciones. Por favor, tómese un tiempo para familiarizarse con ODBConfig y sus opciones de Driver, quizás siéntese con alguien que sea un poco más técnico y hable sobre ello durante uno o dos minutos. Será recompensado.

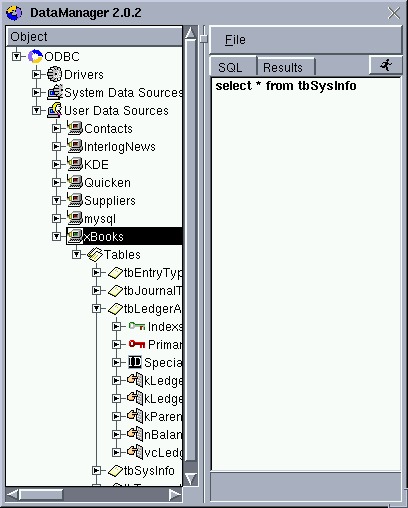

Uso del DataManager

El DataManager es una gran herramienta gráfica para explorar sus fuentes de datos. Le permite explorar sus Fuentes de Datos de una manera similar a la exploración de su sistema de archivos. El DataManager (ver Imagen 6) está dividido en dos vistas. A la izquierda se encuentra la vista en árbol. La vista en árbol es donde puede desglosar la información que le interese. A la derecha tiene una vista detallada. La vista detallada muestra cualquier detalle que pueda estar disponible para el elemento seleccionado en la vista en árbol.

Al igual que ODBCConfig, puede ejecutar el DataManager de varias formas. Una forma es ir a un intérprete de comandos e introducir el comando DataManager. Aparecerá una ventana similar a la de la Imagen 6.

Imagen 6

A continuación, despliegue los nodos para acceder a la información que le interese. Se le pedirá que inicie sesión si intenta profundizar más allá de una Fuente de Datos. En ese caso, introduzca el nombre de usuario y la contraseña que le proporcionó el administrador de la base de datos o el administrador del sistema. Sabrá que ha iniciado sesión cuando la pequeña pantalla del ordenador cambie de Rojo a Verde.

Una de las Vistas Detalladas más interesantes se produce cuando selecciona un elemento de Fuente de Datos en la Vista en árbol cuando ha iniciado sesión en ella (la pequeña pantalla del ordenador es Verde). La Vista Detallada es un editor SQL. Esto sólo es útil si conoce el lenguaje de comandos SQL, pero para aquellos que no lo conocen... puede ser muy útil.

Resumen

La herramienta DataManager es una buena manera de probar un DSN y luego ver qué recursos están disponibles dentro de la fuente de datos. También es muy fácil de usar.

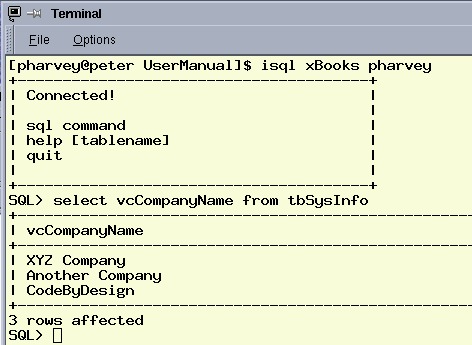

Usando isql

Esta es una herramienta de línea de comandos. Esto significa que puedes utilizarla incluso si no estás trabajando en un Escritorio Gráfico (por ejemplo; en una sesión telnet). Esta herramienta está diseñada para usos más avanzados de unixODBC. Puede utilizar isql para probar una conexión, pero está diseñado para ser utilizado por aquellos que tienen experiencia con el Lenguaje de Consulta Estructurado (SQL). Probablemente no quieras utilizar esta herramienta si no estás familiarizado con SQL.

isql le permite;

- conectarse a su Fuente de Datos (usando un DSN)

- enviar comandos SQL a la Fuente de Datos

- recibir resultados de la Fuente de Datos

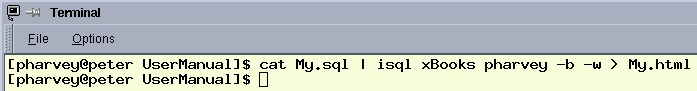

Esta herramienta puede actuar en modo batch o en modo interactivo. La Imagen 3 muestra una simple sesión interactiva.

Imagen 3

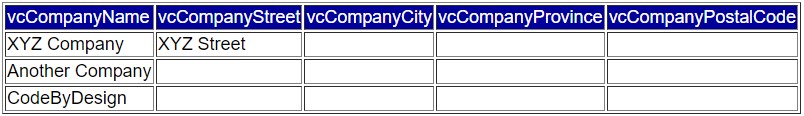

La Imagen 4 muestra un ejemplo de isql en modo batch. Observe que se le indica que ejecute una consulta similar a la anterior, pero esta vez procedente de un archivo ( Mi.sql ).

Imagen 4

El ejemplo de la Imagen 4 también formatea los resultados en una tabla HTML y los envía a un nuevo archivo ( Mi.html ). La Imagen 5 muestra la tabla HTML resultante.

Imagen 5

Resumen

isql es una potente herramienta para trabajar SQL y acceder a su fuente de datos, pero es más para el usuario avanzado.

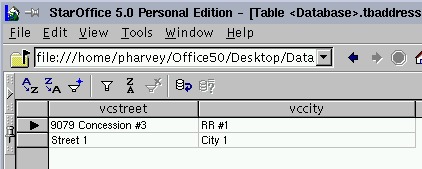

StarOffice 5

StarOffice es una aplicación similar en objetivos a MS Office. Puede descargarse una versión gratuita, para uso no comercial, desde el sitio web de StarDivisions. La Imagen 7 muestra una tabla PostgreSQL siendo explorada en StarOffice. Puede utilizar datos ODBC, pero puede resultar complicado ponerlo en marcha. He aquí algunas cosas a tener en cuenta sobre el uso de StarOffice con unixODBC. Asegúrese de que unixODBC está instalado en su máquina antes de intentar usar ODBC de StarOffice en UNIX.

Imagen 7

Q. StarOffice desaparece cuando intento cargar una lista de DSN ODBC y aparece un error en mi ventana de terminal sobre la falta de algún archivo de biblioteca...

A. Si tiene StarOffice 5.0 puede intentar añadir lo siguiente a su script de inicio de soffice export LD_PRELOAD=/usr/lib/libodbc.so Su script de inicio de soffice se encuentra en Office50/bin/soffice y puede editarse con cualquier editor de texto. Si no está seguro de dónde está libodbc.so o dónde está soffice, puede utilizar el comando find de UNIX.

Sin embargo, con la versión de StarOffice 5.1 y posteriores, todo lo que tiene que hacer es añadir la ruta a libodbc.so a /etc/ld.so.conf o a su variable de entorno LD_LIBRARY_PATH.

Q. ¿Funcionan todos los controladores ODBC con StarOffice?

A. StarOffice es muy exigente con los controladores ODBC. StarOffice necesita muchas características ODBC para aceptar un controlador. Dos controladores que se sabe que funcionan son: 1. PostgreSQL y 2. MySQL. Se está trabajando activamente en otros controladores.

Resumen

StarOffice es una "estrella" en ascenso en el mundo UNIX. Puede combinar StarOffice con unixODBC para acceder a sus datos. Con StarOffice y unixODBC puede extraer sus datos en una hoja de cálculo, un procesador de textos o incluso crear formularios web basados en sus datos.

Conclusión

unixODBC viene con una variedad de herramientas útiles y potentes que le permiten configurar su acceso ODBC y trabajar con sus datos ODBC. Familiarizarse con estas herramientas es un gran comienzo para utilizar tu ODBC en aplicaciones como procesadores de texto, hojas de cálculo e incluso aplicaciones desarrolladas en tu empresa de empleo. Espero que las disfrute. Envíeme sus comentarios y/o sugerencias por correo electrónico, [email protected].

December 27, 2023

Read post

En su edición del 5 de enero de 2013, The Economist publicó esta carta mía:

SIR - El índice de masa corporal con el que usted (y el Servicio Nacional de Salud) cuentan para evaluar la obesidad es una medida extraña. Vivimos en un mundo tridimensional y, sin embargo, el IMC se define como el peso dividido por la altura al cuadrado. Se inventó en la década de 1840, antes de las calculadoras, cuando una fórmula tenía que ser muy simple para ser utilizable. Como consecuencia de esta definición infundada, millones de personas bajas se creen más delgadas de lo que son, y millones de personas altas se creen más gordas.

Nick Trefethen

Profesor de análisis numérico

Universidad de Oxford

La aparición de esta carta, ciertamente muy dura, ha dado lugar a comunicaciones de muchas personas de todo el mundo, y me gustaría explicar una fórmula que creo que valdría la pena considerar como alternativa.

Fórmula actual: IMC = peso(kg)/altura(m)^2 = 703*peso(lb)/altura(pulg)^2.

Lo extraño es la aparición de ese exponente 2, aunque nuestro mundo sea tridimensional. Se podría pensar que el exponente debería ser simplemente 3, pero eso no coincide en absoluto con los datos. Se sabe desde hace tiempo que las personas no se escalan de forma perfectamente lineal a medida que crecen. Propongo que una mejor aproximación a los tamaños y formas reales de los cuerpos sanos podría venir dada por un exponente de 2,5. Así pues, he aquí la fórmula que creo que merece la pena considerar como alternativa al IMC estándar:

Nueva fórmula: IMC = 1,3*peso(kg)/altura(m)^2,5 = 5734*peso(lb)/altura(pulg)^2,5

Los números 1,3 y 5734 están diseñados para que la lectura del IMC no cambie para un adulto de estatura media, que yo considero de unas 66,5 pulgadas, es decir, 1,69 metros. (La raíz cuadrada de 1,69 es 1,3.) Para encontrar su "Nuevo IMC", pruebe la Nueva Calculadora de IMC escrita por Nick Hale.

¿Estos números son "correctos"? No, porque los seres humanos son complicados y cualquier fórmula de IMC sólo proporciona un número. Ningún número puede ser correcto y, de hecho, la extrema dependencia de las instituciones médicas y aseguradoras actuales de una fórmula simple me preocupa mucho. Pero quizá esta fórmula revisada refleje mejor que la estándar cómo el peso de los adultos sanos depende realmente de su estatura.

¿Habría alguna diferencia? Pues sí. A grandes rasgos, cada persona de 1,80 metros de altura perdería un punto de su IMC y cada persona de 1,50 metros ganaría un punto. Son millones de personas. Si las nuevas cifras dieran una indicación más precisa de los problemas de salud reales, esto podría ser un cambio significativo para mejor.

¿Qué hay de la densidad muscular frente a la grasa? Oímos hablar de ello con frecuencia en los debates sobre el IMC (incluso en el artículo de The Economist al que respondía, que mencionaba a los levantadores de pesas olímpicos), pero se trata de un efecto menor. El músculo es un 18% más denso que la grasa. Esto significa que si se ejercitara heroicamente tanto que convirtiera el 10% de su volumen corporal de grasa a músculo (¡vaya!), su lectura del IMC subiría sólo un 1,8%. Eso es mucho menos que las correcciones que acabamos de mencionar para las personas bajas o altas.

¿Qué ocurre con los hombres y las mujeres? Es una pregunta fascinante. Por término medio, las mujeres son un 8% más bajas que los hombres, por lo que si pasamos del IMC actual al nuevo IMC, el valor típico de una mujer subiría un 2% y el de un hombre bajaría un 2%. Puede parecer poco, pero es alrededor de medio punto de IMC, por lo que llevaría a muchas personas más allá de los límites normal/sobrepeso o sobrepeso/obesidad (25 y 30, respectivamente). A veces se dice que las mujeres pueden tener un IMC más alto que los hombres antes de sufrir los efectos de la obesidad. De ser cierto, ¿se trata en parte de una anomalía causada por la definición actual de IMC? No lo sé.

Debo terminar subrayando que soy matemático aplicado, no médico ni epidemiólogo. Las nuevas fórmulas propuestas más arriba no se basan en estudios epidemiológicos, y pueden no suponer una mejora por todo tipo de razones. Para hacerse una idea de la complejidad de la cuestión del IMC, un buen lugar para empezar es el artículo de Wikipedia sobre el tema, y para un artículo epidemiológico clave que apoya el uso del exponente 2,0, véase S. B. Heymsfield et al., American Journal of Clinical Nutrition, 2007. La obesidad será uno de los mayores problemas sanitarios del siglo XXI en todo el mundo. Si se va a depositar una gran confianza en una única fórmula para evaluarla, la justificación de esa fórmula merece un debate cuidadoso.

-----------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------

[El profesor Alain Goriely, de Oxford, ha contribuido con los siguientes fascinantes comentarios. Parece que el propio inventor de la fórmula del IMC mencionó el exponente 2,5].

El IMC fue discutido por primera vez por Quetelet, el primer científico belga (publicó su investigación sobre el peso de los hombres a diferentes edades en 1832, 2 años después de la creación de Bélgica, así que de hecho fue el primero).

El IMC se conoció durante muchos años como índice de Quetelet, hasta que el estadounidense Ancel Keys lo rebautizó como IMC. Pero el propio Quetelet era muy consciente de la [complejidad de la] elección del escalado. He aquí una cita de su libro "Tratado sobre el hombre y el desarrollo de sus facultades", 1842:

Si el hombre aumentara por igual en todas las dimensiones, su peso a diferentes edades sería como el cubo de su estatura. Ahora bien, esto no es lo que realmente observamos. El aumento de peso es más lento, excepto durante el primer año después del nacimiento; entonces, la proporción que acabamos de señalar se observa con bastante regularidad. Pero después de este período, y hasta cerca de la edad de la pubertad, el peso aumenta casi como el cuadrado de la altura. El desarrollo del peso vuelve a ser muy rápido en la pubertad y casi se detiene después de los veinticinco años. En general, no nos equivocamos mucho cuando suponemos que durante el desarrollo, los cuadrados del peso a diferentes edades son como las quintas potencias de la altura, lo que naturalmente lleva a esta conclusión, en apoyo de la constante de gravedad específica, que el crecimiento transversal del hombre es menor que el vertical.

[En el párrafo siguiente, sin embargo, Quetelet sugiere efectivamente el exponente 2 para los adultos plenamente desarrollados].

Original article: https://people.maths.ox.ac.uk/trefethen/bmi.html

August 21, 2023

Read post

por Douglas E. Comer

Artículo Original: https://www.cs.purdue.edu/homes/dec/essay.phd.html

La semana pasada, en la hora del café del coloquio del departamento, varios estudiantes entablaron un debate con el profesorado sobre nuestro programa de doctorado. Quedó claro que muchos de los estudiantes no entendían los conceptos básicos; les sorprendieron algunas de las preguntas y les confundieron algunas de las respuestas.

Estas notas proporcionan información básica sobre el propósito de un programa de doctorado en un intento de ayudar a los estudiantes a decidir si desean cursar un doctorado.

-------------------------------------------------------------------------------------------------------------------------------------------------------------

Fundamentos

El título de Doctor en Filosofía, abreviado Ph.D., es el más alto grado académico que se puede obtener. Dado que la obtención de un doctorado requiere un estudio prolongado y un intenso esfuerzo intelectual, menos del uno por ciento de la población obtiene este título. La sociedad muestra respeto por una persona que posee un doctorado dirigiéndose a ella con el título de “Doctor”.

Para obtener un doctorado hay que lograr dos cosas. En primer lugar, hay que dominar por completo un tema específico. En segundo lugar, hay que ampliar los conocimientos sobre ese tema.

Dominar un tema

Para dominar un tema, el estudiante busca en la literatura publicada y lee todo lo que se ha escrito sobre él. En las disciplinas científicas, el estudiante empieza estudiando obras de referencia general, como los libros de texto. Con el tiempo, el estudiante también debe buscar en revistas académicas, las publicaciones que los científicos utilizan para intercambiar información y registrar los informes de sus investigaciones científicas.

Cada universidad establece las directrices generales que debe seguir un estudiante para obtener el título de doctor, y cada facultad o departamento de una universidad fija los criterios específicos con los que mide el dominio de una materia. Por lo general, para prepararse para el doctorado en un campo determinado, el estudiante debe obtener una licenciatura y un máster (o su equivalente) en ese campo o en un campo estrechamente relacionado. Para demostrar un dominio completo de la materia, es posible que el estudiante deba realizar cursos adicionales de posgrado, mantener una alta media de calificaciones o presentarse a una serie de exámenes especiales. En muchas instituciones, los estudiantes deben hacer las tres cosas.

Dado que los exámenes que se realizan como parte del plan de estudios de un doctorado evalúan conocimientos especializados, son creados y evaluados por un comité de expertos, cada uno de los cuales posee un título de doctor.

Ampliar conocimientos

La esencia de un doctorado, el aspecto que distingue los estudios de doctorado de otros trabajos académicos, puede resumirse en una sola palabra: investigación. Para ampliar el conocimiento, hay que explorar, investigar y contemplar. La comunidad científica utiliza el término investigación para captar esta idea.

En las disciplinas científicas, la investigación suele implicar experimentación, pero la investigación es más que meros experimentos: significa interpretación y comprensión profunda. Para los informáticos, investigar significa buscar para descubrir los principios que subyacen a la computación y la comunicación digitales. Un investigador debe descubrir nuevas técnicas que ayuden a construir o utilizar mecanismos computacionales. Los investigadores buscan nuevas abstracciones, nuevos enfoques, nuevos algoritmos, nuevos principios o nuevos mecanismos.

Para completar un doctorado, cada estudiante debe presentar los resultados de su investigación al profesorado en un documento extenso y formal llamado disertación (más popularmente conocida como tesis). A continuación, el estudiante debe presentar su disertación al profesorado y defender su trabajo en un examen oral.

Relación con los productos

En algunos casos, los resultados de la investigación científica pueden utilizarse para desarrollar nuevos productos o mejorar los ya existentes. Sin embargo, los científicos no utilizan el éxito comercial o los posibles beneficios comerciales como medida de su trabajo; realizan investigaciones para ampliar la comprensión humana y el conjunto de conocimientos que los seres humanos han recopilado. A menudo, los beneficios comerciales de la investigación científica son mucho mayores a largo que a corto plazo.

Actividades de investigación

La investigación en Ciencias de la Computación puede incluir actividades tan diversas como el diseño y la construcción de nuevos sistemas informáticos, la demostración de teoremas matemáticos, la escritura de programas informáticos, la medición del rendimiento de un sistema informático, el uso de herramientas analíticas para evaluar un diseño o el estudio de los errores que cometen los programadores al construir un gran sistema de software. Dado que el investigador elige las actividades apropiadas para responder a cada pregunta que se plantea en una investigación, y dado que surgen nuevas preguntas a medida que avanza la investigación, las actividades de investigación varían de un proyecto a otro y a lo largo del tiempo en un mismo proyecto. Un investigador debe estar preparado para utilizar diversos enfoques y herramientas.

Algunas preguntas

Muchos de ustedes están intentando decidir si cursar un doctorado. He aquí algunas preguntas que podría hacerse.

1. ¿Quiere dedicarse a la investigación?

Antes de matricularse en un programa de doctorado, debe considerar detenidamente sus objetivos a largo plazo. Dado que el doctorado es una formación para la investigación, debe preguntarse si su objetivo a largo plazo es un puesto de investigador. Si lo es, el doctorado es el camino normal hacia la carrera elegida (algunas personas han conseguido un puesto de investigación sin el doctorado, pero son la excepción, no la regla). Si, por el contrario, quieres una carrera no relacionada con la investigación, el doctorado definitivamente no es para ti.

2. ¿Desea un puesto académico?

El doctorado es de facto la "tarjeta de acceso" a un puesto académico. Aunque es posible obtener un puesto académico sin un doctorado, las posibilidades son escasas. Las grandes universidades (y la mayoría de las facultades) exigen que todos los miembros de su profesorado tengan un doctorado y se dediquen a la investigación. ¿Por qué? Para asegurarse de que el profesorado tiene conocimientos suficientes para impartir cursos avanzados y para obligarle a mantenerse al día en el campo que ha elegido. El protocolo diplomático del Departamento de Estado de EE.UU. sitúa el título de "profesor" por encima del de “doctor”. Lo hace en reconocimiento de los requisitos académicos: la mayoría de los catedráticos son doctores, pero no todos los doctores son catedráticos.

3. ¿Tienes lo que hay que tener?

Es difícil para una persona evaluar sus propias capacidades. Las siguientes directrices y preguntas pueden ser de ayuda:

Inteligencia:

En sus cursos universitarios y de posgrado, ¿estuvo más cerca de los primeros de su clase o de los últimos? ¿Qué tal le fue en el GRE u otros exámenes estandarizados?

Tiempo:

¿Está preparado para afrontar un proyecto de mayor envergadura que cualquier otro que haya emprendido antes? Debes comprometerte a trabajar duro durante varios años. ¿Estás dispuesto a reducir o renunciar a otras actividades?

Creatividad:

Los descubrimientos de la investigación suelen surgir cuando se observan hechos antiguos de una forma nueva. ¿Brilla usted cuando resuelve problemas? ¿Le gustan los rompecabezas? ¿Se le da bien resolverlos? En la escuela, ¿le gustaban o le costaban las matemáticas avanzadas?

Curiosidad intensa:

¿Siempre ha sentido la necesidad de entender el mundo que le rodea y averiguar cómo funcionan las cosas? Una curiosidad natural facilita la investigación. ¿Cumplió los requisitos mínimos o exploró más por su cuenta?

Adaptabilidad:

La mayoría de los estudiantes no están preparados para estudiar un doctorado. Les resulta inesperadamente diferente a los cursos. De repente, se ven inmersos en un mundo en el que nadie conoce las respuestas, por lo que a veces fracasan. ¿Puede adaptarse a nuevas formas de pensar? ¿Puede tolerar la búsqueda de respuestas incluso cuando nadie conoce las preguntas precisas?

Automotivación:

Cuando un estudiante termina sus estudios universitarios, ya se ha acostumbrado a recibir las notas de cada asignatura cada semestre. En un programa de doctorado, el trabajo no se divide ordenadamente en cursos separados, los profesores no dividen las tareas en pequeños trabajos y el estudiante no recibe una calificación por cada pequeño paso. ¿Tienes la motivación suficiente para seguir trabajando por un objetivo sin que te animen día a día?

Competitividad:

Si decide matricularse en un programa de doctorado, competirá con otros en la cima. Y lo que es más importante, una vez que se gradúe, entre sus compañeros se encontrarán algunas de las personas más brillantes del mundo. Se le medirá y juzgará en comparación con ellos. ¿Estás dispuesto a competir a nivel de doctorado?

Madurez:

En comparación con los cursos, que están cuidadosamente planificados por un profesor, los estudios de doctorado están menos estructurados. Tendrás más libertad para fijar tus propios objetivos, determinar tu horario diario y seguir ideas interesantes. ¿Está preparado para aceptar la responsabilidad que conllevan estas libertades adicionales? Tu éxito o fracaso en la investigación de doctorado depende de ello.

Algunas advertencias:

A veces, los estudiantes se matriculan en un programa de doctorado por razones equivocadas. Al cabo de un tiempo, se dan cuenta de que los requisitos les abruman. Antes de empezar, hay que darse cuenta de que un doctorado no es:

Prestigioso en sí mismo

Casi todos los que han obtenido un doctorado están orgullosos de sus esfuerzos y del resultado. Sin embargo, debe comprender que, una vez que se gradúe, trabajará entre un grupo de científicos que poseen cada uno un título de doctor. (Un miembro del profesorado solía reprender a los arrogantes estudiantes de posgrado diciéndoles: "No entiendo por qué crees que es un logro tan grande: ¡todos mis amigos tienen un doctorado!").

Una garantía de respeto a todas tus opiniones

Muchos estudiantes creen que, una vez obtenido el doctorado, la gente respetará automáticamente todas sus opiniones. Sin embargo, aprenderás que poca gente asume que un doctorado en una materia te convierte automáticamente en una autoridad sobre los demás. Esto es especialmente cierto en la comunidad científica: el respeto hay que ganárselo.

Un objetivo en sí mismo

Un doctorado te prepara para la investigación. Si lo único que quiere es un diploma para colgar en la pared, hay formas mucho más sencillas de obtenerlo. Cuando se licencie, tendrá ocasión de comparar sus logros con los de otros científicos. Te darás cuenta de que lo que cuenta es el trabajo de investigación acumulado después de que un científico termine su educación formal.

Una garantía de empleo

Cuando una economía se ralentiza, todos pueden verse perjudicados. De hecho, algunas empresas reducen la investigación antes de reducir la producción, lo que hace especialmente vulnerables a los doctores. Además, una vez que una persona obtiene el doctorado, muchas empresas no la contratan para un puesto que no sea de investigación. Como en la mayoría de las profesiones, la continuidad en el empleo depende del rendimiento continuado.

Una forma práctica de impresionar a tu familia o amigos

Puede que tu madre se sienta orgullosa y emocionada cuando te matricules en un programa de doctorado. Al fin y al cabo, se imagina que pronto podrá presumir de su hijo, “el doctor”. Sin embargo, el deseo de impresionar a los demás no es motivación suficiente para el esfuerzo que requiere.

Algo que puedes “intentar” para saber lo listo que eres

Lo siento, pero no funciona así. A menos que te comprometas totalmente, fracasarás. Tendrás que trabajar muchas horas, enfrentarte a muchas decepciones, poner a prueba tus capacidades mentales y aprender a encontrar el orden entre hechos aparentemente caóticos. A menos que haya adoptado el objetivo a largo plazo de convertirse en investigador, las exigencias del día a día le agotarán. Las exigencias te parecerán innecesariamente altas; el rigor, injustificado. Si sólo lo consideras un examen, acabarás abandonando.

El único tema de investigación al que te dedicarás

Muchos estudiantes cometen el error de considerar su tema de doctorado como un área de investigación para toda la vida. Asumen que cada investigador sólo trabaja en un área, siempre persigue el mismo tema dentro de esa área y siempre utiliza las mismas herramientas y enfoques. Los investigadores experimentados saben que surgen nuevas preguntas constantemente y que las antiguas pueden perder interés con el paso del tiempo o el descubrimiento de nuevos hechos. Los mejores cambian de tema y de área. Eso les mantiene frescos y estimula el pensamiento. Prepárate para el cambio.

Más fácil que entrar en el mercado laboral

Después de empezar, el camino hacia el doctorado se vuelve mucho más empinado. El profesorado impone restricciones a su estudio y no permite que los estudiantes improductivos permanezcan en el programa.

Mejor que las alternativas

Para muchos estudiantes, el doctorado puede ser una maldición. Deben elegir entre estar a la cabeza entre los que tienen un máster o ser un investigador mediocre. A veces, los profesores aconsejan a los estudiantes que elijan entre ser "capitán del equipo B" o "jugador de banquillo" en el equipo A. Cada uno debe decidir lo que quiere. Cada uno debe decidir lo que quiere y qué profesión le estimulará más. Pero los estudiantes deben ser realistas sobre sus capacidades. Si realmente no pueden determinar su posición, pregunten a los miembros de la facultad.

Una forma de ganar más dinero

Aunque desde hace un par de años no tenemos estadísticas, los estudiantes de postgrado solían calcular el "sueldo" utilizando los salarios iniciales de los puestos de doctorado y máster, el tiempo medio necesario para obtener un doctorado, el valor de las opciones sobre acciones y el rendimiento actual de las inversiones. Durante un periodo de al menos cinco años que conozcamos, la rentabilidad fue claramente negativa. Baste decir que uno debe elegir la investigación porque le gusta; un doctorado no es el camino óptimo hacia la riqueza.

Las buenas noticias:

A pesar de todas nuestras advertencias, estamos orgullosos de habernos doctorado y de nuestros logros en investigación. Si tiene la capacidad y el interés, la carrera investigadora puede reportarle recompensas inigualables en cualquier otra profesión. Conocerá y trabajará con algunas de las personas más brillantes del planeta. Alcanzará ideas fuera de su alcance y, al hacerlo, ampliará sus capacidades intelectuales. Resolverá problemas que no se han resuelto antes. Explorará conceptos desconocidos hasta ahora. Descubrirás principios que cambiarán la forma de utilizar los ordenadores.

La alegría de investigar:

Un colega resumió la forma en que muchos investigadores sienten su profesión. Cuando le preguntaron por qué pasaba tantas horas en el laboratorio, señaló que las alternativas eran irse a casa, donde haría lo mismo que millones de personas, o trabajar en su laboratorio, donde podría descubrir cosas que ningún otro ser humano había descubierto jamás. La sonrisa de su cara lo decía todo: para él, trabajar en investigación era pura alegría.

May 15, 2023

Read post

Por Chris Lattner

Original article: blog.llvm.org/2011/05/what-every-c-programmer-should-know.html

May 13, 2011

La gente de vez en cuando pregunta por qué el código compilado con LLVM a veces genera señales SIGTRAP cuando el optimizador está activado. Después de indagar, encuentran que Clang generó una instrucción "ud2" (suponiendo código X86) - la misma que es generada por __builtin_trap(). Hay varias cuestiones en juego aquí, todas centradas en el comportamiento indefinido en el código C y cómo LLVM lo maneja.

Esta entrada de blog (la primera de una serie de tres) intenta explicar algunos de estos problemas para que puedas entender mejor las compensaciones y complejidades implicadas, y quizás aprender un poco más de los lados oscuros de C. Resulta que C no es un "ensamblador de alto nivel" como a muchos programadores experimentados de C (particularmente gente con un enfoque de bajo nivel) les gusta pensar, y que C++ y Objective-C han heredado directamente un montón de problemas de él.

Introducción al comportamiento indefinido

Tanto el LLVM IR como el lenguaje de programación C tienen el concepto de "comportamiento indefinido". El comportamiento indefinido es un tema amplio con muchos matices. La mejor introducción que he encontrado al respecto es un artículo en el Blog de John Regehr. La versión corta de este excelente artículo es que muchas cosas aparentemente razonables en C en realidad tienen un comportamiento indefinido, y esta es una fuente común de errores en los programas. Más allá de eso, cualquier comportamiento indefinido en C da licencia a la implementación (el compilador y el tiempo de ejecución) para producir código que formatea tu disco duro, hace cosas completamente inesperadas, o cosas peores. De nuevo, recomiendo encarecidamente la lectura del artículo de John.

El comportamiento indefinido existe en los lenguajes basados en C porque los diseñadores de C querían que fuera un lenguaje de programación de bajo nivel extremadamente eficiente. En cambio, lenguajes como Java (y muchos otros lenguajes "seguros") han evitado el comportamiento indefinido porque quieren un comportamiento seguro y reproducible entre implementaciones, y están dispuestos a sacrificar rendimiento para conseguirlo. Aunque ninguno de los dos es "el objetivo correcto al que aspirar", si eres un programador de C realmente deberías entender qué es el comportamiento indefinido.

Antes de entrar en detalles, vale la pena mencionar brevemente lo que se necesita para que un compilador obtenga un buen rendimiento de una amplia gama de aplicaciones C, porque no hay una solución mágica. A un nivel muy alto, los compiladores producen aplicaciones de alto rendimiento a) haciendo un buen trabajo en los algoritmos básicos como la asignación de registros, la programación, etc. b) conociendo montones y montones de "trucos" (por ejemplo, optimizaciones peephole, transformaciones de bucle, etc.), y aplicándolos siempre que sea rentable. c) siendo buenos en la eliminación de abstracciones innecesarias (por ejemplo, redundancia debido a macros en C, funciones inlining, eliminación de objetos temporales en C++, etc.) y d) no arruinando nada. Aunque cualquiera de las optimizaciones siguientes pueda parecer trivial, resulta que ahorrar sólo un ciclo de un bucle crítico puede hacer que algún códec funcione un 10% más rápido o consuma un 10% menos de energía.

Ventajas del Comportamiento Indefinido en C, con Ejemplos

Antes de entrar en el lado oscuro del comportamiento indefinido y la política y el comportamiento de LLVM cuando se utiliza como compilador de C, pensé que sería útil considerar algunos casos específicos de comportamiento indefinido, y hablar de cómo cada uno permite un mejor rendimiento que un lenguaje seguro como Java. Puedes ver esto como "optimizaciones habilitadas" por la clase de comportamiento indefinido o como la "sobrecarga evitada" que se requeriría para hacer cada caso definido. Aunque el optimizador del compilador podría eliminar algunas de estas sobrecargas algunas veces, hacerlo en general (para cada caso) requeriría resolver el problema de detención y muchos otros "retos interesantes".

También vale la pena señalar que tanto Clang como GCC definen algunos comportamientos que el estándar C deja sin definir. Las cosas que voy a describir son a la vez indefinidas según el estándar y tratadas como comportamiento indefinido por ambos compiladores en sus modos por defecto.

Uso de una variable no inicializada: Esto es comúnmente conocido como fuente de problemas en los programas C y existen muchas herramientas para detectarlos: desde advertencias del compilador hasta analizadores estáticos y dinámicos. Esto mejora el rendimiento al no requerir que todas las variables se inicialicen a cero cuando entran en el ámbito (como hace Java). Para la mayoría de las variables escalares, esto causaría poca sobrecarga, pero las matrices de pila y la memoria malloc'd incurrirían en un memset del almacenamiento, lo que podría ser bastante costoso, sobre todo porque el almacenamiento suele sobrescribirse completamente.

Desbordamiento de entero con signo: Si la aritmética en un tipo 'int' (por ejemplo) se desborda, el resultado es indefinido. Un ejemplo es que no se garantiza que "INT_MAX+1" sea INT_MIN. Este comportamiento permite ciertas clases de optimizaciones que son importantes para algunos códigos. Por ejemplo, saber que INT_MAX+1 es indefinido permite optimizar "X+1 > X" a "verdadero". Saber que la multiplicación "no puede" desbordarse (porque hacerlo sería indefinido) permite optimizar "X*2/2" a "X". Aunque esto puede parecer trivial, este tipo de cosas son comúnmente expuestas por inlining y expansión de macros. Una optimización más importante que esto permite es para "<=" bucles como este:

for (i = 0; i <= N; ++i) { ... }

En este bucle, el compilador puede asumir que el bucle iterará exactamente N+1 veces si "i" es indefinido por desbordamiento, lo que permite una amplia gama de optimizaciones de bucle. Por otro lado, si la variable está definida para envolverse en el desbordamiento, entonces el compilador debe asumir que el bucle es posiblemente infinito (lo que ocurre si N es INT_MAX) - lo que deshabilita estas importantes optimizaciones de bucle. Esto afecta particularmente a las plataformas de 64 bits ya que mucho código utiliza "int" como variables de inducción.

Vale la pena señalar que el desbordamiento sin signo está garantizado para ser definido como desbordamiento de complemento a 2 (envolvente), por lo que siempre se pueden utilizar. El coste de definir el desbordamiento de enteros con signo es que este tipo de optimizaciones simplemente se pierden (por ejemplo, un síntoma común es una tonelada de extensiones de signo dentro de bucles en objetivos de 64 bits). Tanto Clang como GCC aceptan la bandera "-fwrapv" que fuerza al compilador a tratar el desbordamiento de enteros con signo como definido (aparte de la división de INT_MIN por -1).

Desbordamiento de cantidades: Desplazar un uint32_t 32 bits o más no está definido. Mi suposición es que esto se originó porque las operaciones de desplazamiento subyacentes en varias CPU hacen cosas diferentes con esto: por ejemplo, X86 trunca la cantidad de desplazamiento de 32 bits a 5 bits (por lo que un desplazamiento de 32 bits es lo mismo que un desplazamiento de 0 bits), pero PowerPC trunca las cantidades de desplazamiento de 32 bits a 6 bits (por lo que un desplazamiento de 32 produce cero). Debido a estas diferencias de hardware, el comportamiento es completamente indefinido por C (por lo tanto, el desplazamiento de 32 bits en PowerPC podría formatear su disco duro, *no* está garantizado que produzca cero). El coste de eliminar este comportamiento indefinido es que el compilador tendría que emitir una operación extra (como una 'y') para los desplazamientos de variables, lo que los haría el doble de caros en CPUs comunes.

Desreferencias de Punteros Salvajes y Accesos a Matrices Fuera de Límites: La desreferenciación de punteros aleatorios (como NULL, punteros a memoria libre, etc) y el caso especial de acceder a un array fuera de límites es un error común en las aplicaciones C que esperemos no necesite explicación. Para eliminar esta fuente de comportamiento indefinido, los accesos a arrays tendrían que ser comprobados por rango, y la ABI tendría que ser cambiada para asegurarse de que la información de rango sigue alrededor de cualquier puntero que pudiera estar sujeto a la aritmética de punteros. Esto tendría un coste extremadamente alto para muchas aplicaciones numéricas y de otro tipo, además de romper la compatibilidad binaria con todas las bibliotecas C existentes.

Desreferenciación de un puntero NULL: contrariamente a la creencia popular, la desreferenciación de un puntero nulo en C no está definida. No está definido para atrapar, y si se mmappea una página en 0, no está definido para acceder a esa página. Esto se sale de las reglas que prohíben la desreferenciación de punteros salvajes y el uso de NULL como centinela. El hecho de que las desreferencias a punteros NULL no estén definidas permite una amplia gama de optimizaciones: por el contrario, Java hace que no sea válido para el compilador mover una operación de efecto secundario a través de cualquier desreferencia a punteros a objetos que el optimizador no pueda probar que no son NULL. Esto penaliza significativamente la programación y otras optimizaciones. En los lenguajes basados en C, la indefinición de NULL permite un gran número de optimizaciones escalares sencillas que quedan expuestas como resultado de la expansión de macros y el inlining.

Si estás usando un compilador basado en LLVM, puedes hacer dereferencia a un puntero nulo "volátil" para obtener un fallo si eso es lo que estás buscando, ya que las cargas y almacenamientos volátiles generalmente no son tocados por el optimizador. Actualmente no existe ninguna bandera que permita que las cargas aleatorias de punteros NULL sean tratadas como accesos válidos o que haga que las cargas aleatorias sepan que su puntero está "autorizado a ser nulo".

Violación de las reglas de tipo: Es un comportamiento indefinido convertir un int* en un float* y desreferenciarlo (accediendo al "int" como si fuera un "float"). C requiere que este tipo de conversiones de tipo se realicen a través de memcpy: usar conversiones de punteros no es correcto y resulta en un comportamiento indefinido. Las reglas para esto son bastante matizadas y no quiero entrar en detalles aquí (hay una excepción para char*, los vectores tienen propiedades especiales, las uniones cambian cosas, etc). Este comportamiento permite un análisis conocido como "Type-Based Alias Analysis" (TBAA) que es utilizado por una amplia gama de optimizaciones de acceso a memoria en el compilador, y puede mejorar significativamente el rendimiento del código generado. Por ejemplo, esta regla permite a clang optimizar esta función:

float *P;

void matriz_cero() {

int i;

for (i = 0; i < 10000; ++i)

P[i] = 0.0f;

}

en "memset(P, 0, 40000)". Esta optimización también permite sacar muchas cargas de los bucles, eliminar subexpresiones comunes, etc. Esta clase de comportamiento indefinido puede desactivarse pasando la bandera -fno-strict-aliasing, que desautoriza este análisis. Cuando se pasa esta bandera, Clang se ve obligado a compilar este bucle en 10000 almacenes de 4 bytes (lo que es varias veces más lento), porque tiene que asumir que es posible que cualquiera de los almacenes cambie el valor de P, como en algo como esto:

int main() {

P = (float*)&P; // la conversión causa una violación TBAA en zero_array.

zero_array();

}

Este tipo de abuso de tipos es bastante infrecuente, razón por la cual el comité del estándar decidió que las significativas ganancias de rendimiento merecían la pena por el resultado inesperado de los lanzamientos de tipos "razonables". Vale la pena señalar que Java obtiene los beneficios de las optimizaciones basadas en tipos sin estos inconvenientes, ya que no tiene ningún tipo de fundido de punteros inseguro en el lenguaje.

De todos modos, espero que esto te dé una idea de algunas de las clases de optimizaciones permitidas por el comportamiento indefinido en C. Hay muchas otras clases, por supuesto, incluyendo violaciones del punto de secuencia como "foo(i, ++i)", condiciones de carrera en programas multihilo, violar 'restrict', dividir por cero, etc.

En nuestro próximo post, discutiremos por qué el comportamiento indefinido en C es algo bastante aterrador si el rendimiento no es tu único objetivo. En nuestro último post de la serie, hablaremos de cómo lo manejan LLVM y Clang.

Comandos de Expresión Regulares

Lo que Todo Programador de C Debe Saber Sobre el Comportamiento Indefinido #2/3

November 27, 2023

Read post

Artículo original: https://sites.cc.gatech.edu/fac/Spencer.Rugaber/txt/researchPaper.html

Por: Spencer Rugaber

30 de agosto de 2006 Instituto Tecnológico de Georgia

En una universidad, a menudo se te pide que leas un artículo o documento académico. Aquí hay algunas pautas y preguntas que puedes hacerte mientras lo haces.

- Echa un vistazo al libro, Cómo leer un libro (Mortimer J. Adler y Charles Van Doren, Simon and Schuster, 1940). Ofrece muchos consejos útiles para mejorar tus habilidades de lectura.

- Es posible que no puedas entender todo el artículo en una sola lectura. En la primera pasada, obtén la idea general, busca cualquier palabra de vocabulario que no entiendas y anota tus preguntas pendientes. Luego haz otra pasada en la que encajes las piezas del rompecabezas.

- Identifica la tesis del artículo y exprésala en una oración simple. La tesis es la idea principal que el autor intenta convencerte. A veces es sorprendentemente difícil determinar esto.

- Después de leer el artículo, pregúntate si el autor te ha convencido o no de la tesis. Si no, ¿por qué no? ¿Fue defectuosa la lógica? ¿No se proporcionó suficiente evidencia?

- Resume explícitamente el argumento del autor. Es decir, escribe los puntos del argumento del autor y las razones dadas para cada punto.

- ¿Cuál es el otro lado del tema? A menudo los autores lo indicarán explícitamente, con mayor o menor grado de parcialidad. Incluso si el autor no menciona el otro lado en absoluto, debes intentar resumir el otro lado del argumento. Después de todo, si no hay otro lado, ¿por qué se escribió el artículo en primer lugar?

- ¿Hay preguntas que te quedan rondando la cabeza? A menudo, un autor planteará explícitamente "Trabajo futuro" que se puede realizar para dar seguimiento al trabajo presentado. Por el contrario, el autor puede haber pasado por alto algunas preguntas obvias que el artículo dejó sin respuesta.

- De manera más general, trata de caracterizar el campo en el que está trabajando el autor. Muchas veces el autor hará esto explícitamente hablando de "Trabajo relacionado". Y un autor minucioso discutirá cómo su trabajo difiere del de cada uno de los competidores del autor.

- ¿Cómo valida el autor su trabajo? Es decir, al presentar un caso, un autor debe proporcionar evidencia que lo respalde. Diferentes campos utilizan diferentes tipos de evidencia. Por ejemplo, los matemáticos proporcionan pruebas; los psicólogos hacen experimentos; y los ingenieros a menudo construyen prototipos. Cuidado con los artículos que ofrecen opiniones pero no te dan la evidencia para apoyarlas.

- ¿Cuál fue el estilo del autor? Muchos artículos académicos son bastante (excesivamente) secos, simplemente enunciando los hechos con poco adorno. Otros tienen un carácter más tutorial, utilizando el pronombre en segunda persona ("tú") en lugar del impersonal en tercera persona ("él" / "ella" / "eso"). Algunos usan la voz activa, otros la pasiva. Algunos incluso usan una figura retórica ocasional para animar las cosas.

- Aquí hay otro libro que podrías mirar (Writing Arguments: A Rhetoric with Readings, John D. Ramage, John C. Bean, and June Johnson, Longman Publishers, 2004). Describe las técnicas que los autores usan (o usan mal) al expresar sus posiciones. Comprender las técnicas que los autores usan en su escritura puede mejorar tu capacidad de lectura...

June 22, 2023

Read post

Michael Buckland

School of Information Management and Systems, Universidad de California, Berkeley, CA 94720-4600

Esta ponencia fue presentada en la 35ª Conferencia Anual de la Association of Records Management and Administrators y publicada en Proceedings (Prairie village, KS: ARMA, 1990), 801-813, y reimpresa con algunos cambios menores en American Archivist, vol 57 (primavera 1994): 3346-351. Esta versión puede diferir ligeramente de las versiones publicadas.

Resumen: La teoría se define como una visión o descripción de la naturaleza de algo. Se examina la naturaleza de la teoría relacionada con la teoría de la gestión de documentos de archivo, incluyendo la recuperación de información, el ciclo de vida de los documentos de archivo y la política de información. La teoría de la gestión documental no debe considerarse de forma aislada y no tiene por qué ser exclusiva de la gestión documental. Se esbozan, con ejemplos, los contextos funcionales, profesionales y educativos de la teoría de la gestión documental.

Introducción

Existen diversas opiniones sobre la teoría de la gestión documental:

- Que existe una teoría bien definida y establecida que rige la práctica de la gestión de archivos;

- Que no existe una teoría que guíe la práctica de la gestión de archivos;

- Que existen varias teorías que sustentan la práctica de la gestión documental, pero pertenecen a disciplinas o ciencias afines y se utilizan siempre que se manifiesta la necesidad de una acción basada en principios.

En este documento, argumentaremos que ninguna de las anteriores es correcta. En su lugar, sugerimos que (i) existe un cuerpo de teoría de la gestión documental que aún no ha sido bien formulado; (ii) partes de esta teoría son y serán cada vez más compartidas con otros campos; y (iii) gran parte de ella es, quizás, aún no debidamente reconocida como teoría. Pero primero tenemos que aclarar nuestros términos. En concreto, antes de abordar la pregunta "¿Existe una teoría de la gestión documental?" o, mejor, "¿Qué es la teoría de la gestión documental?", es necesario abordar la pregunta previa "¿Qué es la teoría?" si no queremos perder el tiempo.

¿Qué es la "teoría"?

El significado original y el sentido subyacente de la palabra "teoría" es una visión o perspectiva de algo. En sus orígenes, la palabra "teoría" está relacionada con la palabra "teatro" (Oxford English Dictionary 1989, v. 7, p. 902). En términos más generales, teoría es la visión o descripción que alguien tiene de la naturaleza de algo. En este sentido general hay teoría de cualquier cosa cuya naturaleza se pueda describir.

Uno de los problemas es que la discusión inteligente de la teoría en la mayoría de las áreas se ha visto desviada por el gran prestigio social de las ciencias matemáticas y experimentales, especialmente desde la Segunda Guerra Mundial. La lógica y la física son inusuales en el sentido de que si uno tiene una opinión sobre la naturaleza de algún aspecto de ellas, generalmente puede expresar su punto de vista (su teoría) de tal manera que pueda ser probada experimentalmente y, tal vez, se descubra que es inadecuada. Encontrar pruebas que apoyen las teorías es relativamente fácil y de utilidad limitada. El esfuerzo de buena fe por refutar las teorías es básico para progresar. Por lo tanto, en estas disciplinas se suele esperar que las teorías puedan enunciarse de forma rigurosa y que puedan ponerse a prueba tratando de refutarlas. (Normalmente, una teoría es una hipótesis o combinación de hipótesis que ha resistido algunas pruebas).

Por desgracia, la gente ha asumido que las actividades que no son ciencias "duras" también deben utilizar el mismo sentido restringido y especializado de teoría. Cuando buscan este tipo de teoría rigurosa y de refutación en el desordenado mundo de las actividades humanas, como la prestación y el uso de servicios de información, no encuentran ninguna -¡como era de esperar!- y esta estrecha idea preconcebida con la teoría rigurosa y formal les disuade de fijarse en la teoría adecuada al tema. (Para un ejemplo de búsqueda infructuosa y mal formulada de teoría, véase Boyce y Kraft 1985). Aristóteles lo sabía mejor: "Es una marca del hombre educado y una prueba de su cultura que en cada tema busque sólo tanta precisión como permita su naturaleza". (Aristóteles 1955, 27-28)

No debería existir una dicotomía rígida entre "teoría" y "práctica", ya que en ambas subyace una cierta visión de lo que está en juego (en realidad, teoría). No obstante, el profesional reflexivo de la gestión documental, al igual que en otros campos útiles, se enfrenta por lo general a la disyuntiva de elegir entre una teoría formal, rigurosa y "respetable", que parece divorciada de las desordenadas realidades cotidianas, y una "teoría" menos formal que refleja, más o menos, la desordenada realidad que se encuentra en la práctica, pero que no se parece mucho a la teoría (Schon 1983, 42-45). El reto para los reflexivos, y especialmente para los académicos, es tratar de salvar la distancia: Elaborar teorías formales que sean más realistas y desarrollar puntos de vista realistas que se enmarquen en términos de principios generales.

¿Hasta qué punto es trivial la gestión de archivos?

Una vez que nos alejamos del absurdo de suponer que la teoría de la gestión de archivos debe tener las características de la teoría de una ciencia formal, la cuestión cambia de si existe una teoría a sobre qué estamos teorizando. Dicho más claramente: ¿Hasta qué punto es trivial o compleja la gestión documental?

Si consideráramos que la gestión documental consiste únicamente en numerar, archivar, buscar y volver a archivar trozos de papel, entonces nuestra visión de la misma -nuestra teoría- también sería bastante trivial. Por muy valiosa que sea esa actividad desde el punto de vista económico, es probable que la teoría no sea muy interesante.

Pero si consideramos la gestión documental como la gestión del acceso a los documentos de trabajo de una organización, entonces surgen algunos aspectos más complejos de los que mencionaré tres ejemplos:

1. Recuperación de información. Buscar la orden de compra nº 1234 es sencillo, basta con buscar su ubicación y transportarla físicamente. Pero, ¿cómo identificar qué registros existen que satisfagan alguna necesidad mal definida? ¿Qué pasa con todos los documentos relacionados con las actividades de una empresa que podrían interpretarse como prueba de discriminación? ¿Cómo encuentra una universidad los documentos que podrían demostrar sus contribuciones al bienestar de la industria local?

La recuperación de información puede incluir hasta tres funciones: (i) obtener físicamente una copia de un documento; (ii) localizar dónde se encuentra actualmente algún documento conocido; e (iii) identificar qué documentos, si los hay, se ajustan a alguna descripción. Las series de documentos están bien definidas, pero es probable que se necesiten más. Se entra en el amplio y complejo campo de la indización, la clasificación, los tesauros, los diccionarios de datos, etc.

2. El ciclo de vida de los registros. Cualquier tipo de servicio de gestión documental puede ser más eficaz y rentable si el gestor se implica en el ciclo de vida completo de los documentos de archivo. Pero la implicación en el ciclo completo conlleva la participación en una amplia variedad de cuestiones: diseño y gestión de formularios, factores humanos y flujo de trabajo, calendarios de conservación y valoración para la retención archivística, tecnología de la información y protección de registros vitales.

3. Política de información. ¿Qué (y quién) determina quién debe y quién no debe tener acceso a los documentos de archivo? Se trata de cuestiones jurídicas y éticas derivadas de la legislación sobre libertad de información y privacidad, secretos comerciales, etcétera. Estas cuestiones son complicadas, contradictorias y de gran importancia, sobre todo para la gestión de archivos en el sector público. Por ejemplo, ¿debe el público tener acceso a algunos o todos los expedientes personales de los funcionarios públicos o tienen prioridad los derechos a la intimidad de dichos funcionarios? ¿Cuándo y por qué motivos pueden mantenerse confidenciales los borradores de documentos de trabajo?

Estos tres ejemplos (recuperación de la información, diseño del ciclo de vida de los documentos de archivo y políticas de información) bastan para indicar que, si se considera que la gestión de documentos de archivo tiene que ver en general con el acceso a los documentos de trabajo de una organización, es difícil no ver la naturaleza del campo como práctica y conceptualmente complicada, como real o potencialmente rica en teorías de un tipo u otro.

La ciencia del avestruz: o ¿qué tiene de particular la gestión documental?

Otro problema de la teoría en la práctica profesional es el deseo de identificar una teoría o ciencia que sea exclusiva de esa ocupación. También esto es imprudente.

Las cuestiones y principios sobre quién debe tener acceso a los documentos de archivo son tanto una cuestión legal como de gestión documental. El concepto de ciclo de vida es común tanto a los archivos como a la gestión documental. Los esquemas de indexación y clasificación también conciernen a la biblioteconomía, la museología, la gestión de bases de datos y otros ámbitos. ¿Es importante? Sí, tiene una importancia positiva porque es beneficioso que otros grupos profesionales también tengan interés en abordar los mismos problemas o problemas relacionados. Lo que se necesita es comunicación y colaboración, no un aislamiento profesional autoimpuesto.

Yo no consideraría que facilitar el acceso a los archivos de una organización carezca de importancia o sea fácil. El prestigio y el respeto vienen de hacer bien una tarea difícil e importante, no de insistir en que uno no es archivero, ni bibliotecario, ni lo que sea. Definir el ámbito de la gestión de documentos de archivo implica también definir qué tipo de teoría sería pertinente. Cuantas más ideas puedan derivarse de otros campos, mejor será el servicio de gestión documental.

Pensemos en un científico que estudia un avestruz. Sin duda, el estudio de los avestruces requiere mucha teoría. Sin embargo, dudo que sea algo exclusivo de los avestruces. Más bien deberíamos esperar formas variantes o casos especiales de teorías también relevantes para otras aves y/u otros animales del mismo hábitat. Uno puede ser un científico del avestruz, pero desconfíe de quien insista en que existe una Ciencia del Avestruz que de algún modo está separada y es independiente de otras disciplinas. Puede que alguien tenga la cabeza en la arena.

Contextos teóricos de la teoría de la gestión documental.

Por "contexto teórico" entendemos un ámbito teórico más amplio en el que encaja la teoría de la gestión documental. Puede haber muchos contextos teóricos. Mencionaremos sólo tres.

1. Contexto funcional. La gestión documental está al servicio de una empresa u otra organización. Por tanto, la misión de un servicio de gestión documental debe estar relacionada con la misión de la organización en su conjunto y apoyarla. La función del programa de gestión documental debe articularse con las funciones de otras partes de la organización: las funciones, necesidades y actividades de los empleados que necesitan acceder a los documentos de archivo; las funciones de otros programas relacionados con la información, como los sistemas de gestión de la información, el procesamiento de datos, la biblioteca y los archivos. En otras palabras, es probable que la teoría de la gestión documental resulte estéril o incompleta si no se relaciona con una visión de la organización en su conjunto. Se trata de algo más que curiosidad académica. Si vamos a afirmar que el papel de la gestión documental es importante, entonces necesitamos tener puntos de vista sobre cómo un buen programa de gestión documental contribuye y apoya la eficacia de la organización.

2. Contexto profesional. La gestión documental puede considerarse un miembro de una familia de sistemas de información basados en la recuperación. No es lo mismo un italiano que un británico, pero ambos son europeos y comparten algunas cosas en común como europeos. Los archivos, las bibliotecas, los programas de gestión documental y las bases de datos corporativas no son lo mismo, pero todos ellos son servicios de información basados en la recuperación y, por tanto, tienen algunas características en común, así como diferencias que los hacen singularmente distintos (Buckland 1982, 1991).

Considerar la gestión documental como miembro de una familia de sistemas de información basados en la recuperación no es algo nuevo. Este punto de vista se adoptó en el movimiento de la "Documentación" a principios de este siglo, especialmente en los escritos de Paul Otlet (1868-1944) (Rayward 1976, 1986). Lo que hoy llamamos gestión de archivos, Otlet lo denominaba "documentación administrativa" y lo consideraba una especialidad importante de la administración. También incluía en la documentación administrativa lo que hoy llamamos Sistemas de Información de Gestión. Otlet escribió varios artículos sobre el tema y sus ideas se aplicaron de forma limitada en Europa (Otlet 1923, 1930, 1934, 350-55; Rayward 1976, 160, 184).

Otlet consideraba que los archivos, la bibliografía, las bibliotecas, los museos y la gestión documental formaban parte del amplio campo de la "Documentación" o "Documentación General" o, como diríamos hoy en día, de la gestión de los recursos de información. En 1923 escribió, un tanto prematuramente, que la documentación administrativa era una rama de la "documentación general", que nacía de la convergencia y luego la fusión de la bibliografía, la administración de archivos e incluso la museología (Otlet 1923, 13).

Otlet fue una figura importante en su época, pero en la actualidad es poco conocido. Sus escritos sólo empiezan a aparecer ahora en inglés (Otlet 1990). Sin embargo, la idea de que la gestión de documentos de archivo (y otros tipos de servicios de información) puede resultar beneficiosa desde el punto de vista teórico y práctico como parte de una familia de profesiones relacionadas con la información y de adoptar un enfoque comparativo ha recibido atención recientemente en Norteamérica (Seibell 1987; Pemberton & Prentice 1990; Buckland, 1991).

3. Contexto intelectual. Otro tipo de contexto es el que podría denominarse "contexto intelectual". ¿De dónde proceden las ideas sobre gestión de archivos y adónde han ido a parar? Dos ejemplos pueden ilustrar este punto. Una de las fuentes de las ideas sobre gestión documental es la teoría archivística. Posner (1940) se burlaba de los archiveros por su afición a buscar sus raíces en la antigua Asiria. Tal vez esa antigua actividad archivística se describa con más precisión como gestión de documentos de archivo antiguos (Walker 1989). El profesor Duranti ha resumido recientemente ese aspecto de la ascendencia intelectual de los gestores de documentos (Duranti 1989).

En la otra dirección, es menos conocido que las ideas actuales de moda en informática sobre el hipertexto y los hipermedios tienen parte de sus raíces en la gestión de documentos de archivo. Una inspiración importante en ese campo ha sido el ensayo visionario "As we may think" de Vannevar Bush (1945). Esta fantasía, redactada en 1939, se basaba en su experiencia con un proyecto financiado por Eastman Kodak y National Cash Register para desarrollar un método más rápido de recuperación de registros comerciales microfilmados utilizando una máquina conocida como "selector rápido". Los selectores rápidos eran básicamente una versión preinformática de la recuperación asistida por ordenador (CAR) en la que las entradas del índice se registraban como patrones en el propio microfilm junto a las imágenes de los documentos. Las entradas del índice se buscaban utilizando una célula fotoeléctrica para detectar coincidencias entre el patrón de índice buscado y los patrones de índice del microfilm. La tecnología del selector rápido fue desarrollada inicialmente a finales de la década de 1920 por Zeiss Ikon en Alemania y más tarde, de los años 30 a los 60, en EE.UU., normalmente para ayudar a localizar y recuperar registros corporativos microfilmados o informes técnicos (Goldberg, 1992; Buckland, 1992; Alexander & Rose, 1964; Stevens, 1968).

Comparación

No se llega muy lejos intentando definir y describir las cosas en sus propios términos. La comparación es la actividad intelectual más básica. Comparar la naturaleza de la gestión documental con otras cosas es una condición necesaria para progresar en el desarrollo de una visión -una teoría- de la gestión documental. Para comprender mejor la gestión de documentos de archivo debemos prestar más atención a la comparación de la gestión de documentos de archivo con otras actividades afines. Sólo mediante un conocimiento profundo de las semejanzas y desemejanzas podemos esperar desarrollar una comprensión profunda de la naturaleza -una teoría- de la gestión de archivos.

Resumen

- Una teoría es una visión de la naturaleza de algo.

- La teoría no debe ser más formal de lo que permita la naturaleza de los fenómenos que debe describir. Las teorías excesivamente formalizadas dejan de describir la realidad de forma útil.

- Cualquier visión de la gestión documental como algo más que el archivo y la búsqueda de documentos proporcionará una base para una teoría no trivial.

- Es probable que pocas partes de la teoría de la gestión de archivos sean exclusivas de la gestión de archivos, aunque sí lo serán su aplicación detallada y su combinación global. La teoría compartida es ventajosa porque significa que otros comparten la motivación de buscar una mejor comprensión.

- La gestión documental puede considerarse en relación con diferentes contextos, por ejemplo, funcional, profesional, intelectual. Cada uno de estos contextos más amplios genera un cuerpo teórico o una oportunidad para desarrollarlo.

Referencias

Alexander, S. N. and F. C. Rose. 1964. The Current Status of Graphic Storage Techniques: Their Potential Application to Library Mechanization. In: Libraries and Automation. Proceeding of the Conference on Libraries and Automation, Warrenton, 1963, ed. by B. E. Markuson. (Washington, DC: Library of Congress, 1964), 111-140.

Aristotle. 1955. The Ethics of Aristotle: The Nichomachean Ethics Translated. (Harmondsworth, UK: Penguin).

Boyce, Bert R. and Donald H. Kraft. 1985. Principles and Theories in Information Science. Annual Review of Information Science and Technology 20:153-78.

Buckland, Michael. 1982. Records Management in its Intellectual Context: Experience at Berkeley. ARMA Quarterly 16:26-28, 30.

Buckland, Michael. 1991. Information and Information Systems. (New York: Praeger).

Buckland, Michael. 1992. Emanuel Goldberg, Electronic Document Retrieval, and Vannevar Bush's Memex. Journal of the American Society for Information Science 43 (May 1992): 284-294.

Bush, Vannevar. 1945. As We may Think. Atlantic Monthly 176:101-106.

Duranti, L. 1989. The Odyssey of Records Management. ARMA Quarterly 23, no. 3 (July 1989): 3-11 and no. 4 (Oct. 1989):3-11.

Goldberg, Emanuel. 1932, 1992. The Retrieval Problem in Photography (1932). Transl. and notes by M. Buckland. Journal of the American Society for Information Science 43 (May 1992): 295-298.

Otlet, Paul. 1923. Manuel de documentation administrative. (IIB publ. 137). (Brussels: Institut International de Bibliographie).

Otlet, Paul. 1930. Sur les possibilités pour les entités administratives d'avoir à tout moment leur situation présentée documentairement. (IIB Publ. 162). (Brussels: Institut International de Bibliographie).

Otlet, Paul. 1934. Traité de documentation. (Brussels: Editiones Mundaneum, 1934. Reprinted Liège, Belgium: Centre de Lecture Publique de la Communauté Française, 1989).

Otlet, Paul. 1990. International Organization and Dissemination of Knowledge: Selected Essays. Transl. and ed. by W. B. Rayward. (FID 684). (Amsterdam: Elsevier).

Oxford English Dictionary. 1989. 2nd ed. (Oxford: Clarendon Press), v. 7, p. 902.

Pemberton, J. Michael and Ann Prentice, eds. 1990. Information Science: The Interdisciplinary Context. (New York: Neal-Schuman).

Posner, E. 1940. Some Aspects of Archival Development since the French Revolution. American Archivist 3 (July 1940):159-172. Reprinted in M. F. Daniels and T. Walch, eds. 1984. A Modern Archives Reader. (Washington, DC: National Archives and Records Service), 3-14.

Rayward,W. Boyd. 1976. The Universe of Information: The Work of Paul Otlet for Documentation and International Organization. (FID 520). (Moscow: VINITI).

Rayward, W. Boyd. 1986. Otlet, Paul-Marie-Ghislain. In: ALA World Encyclopedia of Library and Information Sciences. 2nd ed. (Chicago: American Library Association), 626-28.

Schon, Donald A. 1983. The Reflective Practitioner: How Professionals Think in Action. (New York: Basic Books), 42-45.

Seibell, C. S. 1987. Records Management in its Intellectual Context. Records Management Quarterly 21:3-14, 42 & 49.

Stevens, G. W. W. 1968. Microphotography: Photography and Photofabrication at Extreme Resolution. 2nd ed. (New York: Wiley).

Walker, B. 1989. Records Managers and Archivists: A Survey of Roles. Records Management Quarterly 23 (1989):18-20, 45 & 49.

Original article: people.ischool.berkeley.edu/~buckland/rmtheory.html

July 27, 2023

Read post

La ciencia computacional es hacer ciencia a través de la computación. Se ha convertido en el tercer modo de investigación científica, complementario de la teoría y el experimento. Gracias a los enormes avances en potencia de cálculo, ahora es posible simular computacionalmente procesos cada vez más complicados y realistas.

El diseño, la creación de prototipos, la optimización y el control de procesos tecnológicos dependen de una comprensión fundamental de los fenómenos implicados, sus interacciones y su sensibilidad a los parámetros. Estos fenómenos pueden estudiarse muy eficazmente mediante simulaciones por ordenador basadas en modelos matemáticos que expresan principios físicos.

- Modelización: El primer paso es la "matematización" del proceso, es decir, el desarrollo de un modelo matemático del proceso físico. Suele ser, con mucho, la más difícil.

- Análisis: A continuación, puede utilizarse todo el arsenal de herramientas matemáticas para analizar y comprender las propiedades básicas del modelo matemático e intentar predecir su comportamiento. Aquí es donde cobran importancia las cuestiones teóricas (existencia, unicidad, estabilidad de las soluciones), que a menudo generan problemas desafiantes para la investigación matemática teórica.

- A continuación entra en juego la Computación Científica, que desarrolla métodos numéricos apropiados y eficaces para el problema matemático.

- Programación: Los algoritmos se implementan en un lenguaje informático de alto nivel (Fortran, C, C++).

- Verificación: El código informático se prueba exhaustivamente en problemas/procesos con solución/comportamiento conocidos. Se corrigen los errores y el código se prueba una y otra vez.

- Optimización: El código informático se optimiza para aumentar su robustez, estabilidad y eficacia.

- Paralelización: Los problemas realistas suelen ser muy exigentes desde el punto de vista computacional, por lo que es necesario paralelizar el código para que se ejecute simultáneamente en clusters de multiprocesadores y/o en muchos ordenadores conectados en red.

- Validación: El último paso crucial es la validación del modelo mediante la simulación de un proceso y la comparación de los resultados de las simulaciones numéricas con las mediciones experimentales. Esto puede requerir varias iteraciones de todos los pasos anteriores.

Original article: https://web.math.utk.edu/~vasili/va/descr/

June 12, 2023

Read post

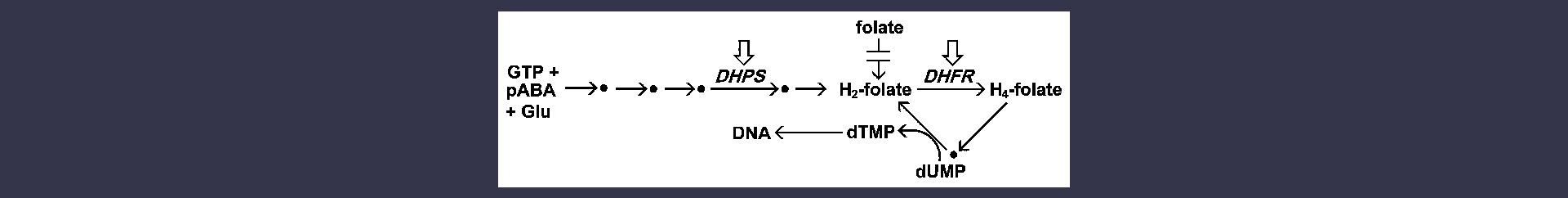

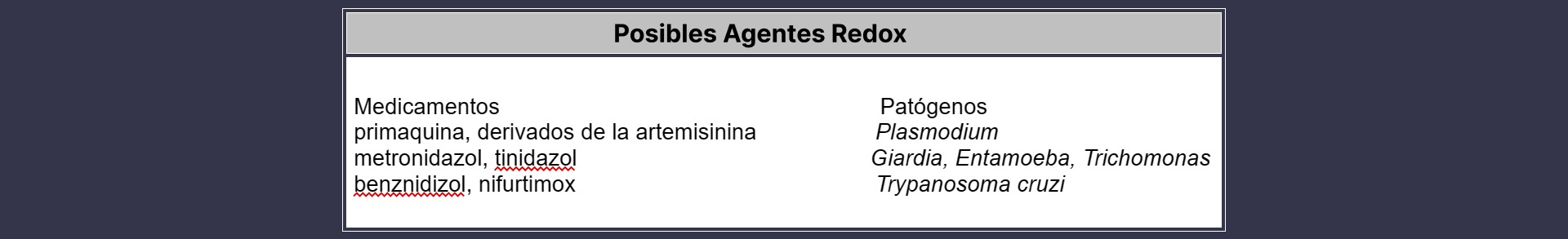

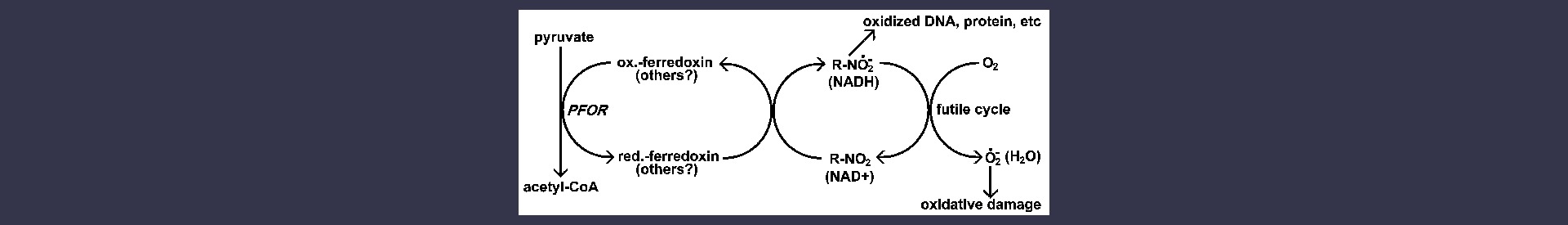

La quimioterapia es el principal medio de tratamiento de las infecciones por protozoos. El éxito de la quimioterapia depende en gran medida de la capacidad de aprovechar las diferencias metabólicas entre el patógeno y el huésped. Un problema al que se enfrenta la quimioterapia es la capacidad del patógeno para mutar y volverse resistente a los fármacos. A continuación se exponen ejemplos concretos de mecanismos de acción y resistencia a los fármacos.

Índice:

- Acción del fármaco

- La cloroquina y la vacuola alimentaria

- Antifolatos

- Fármacos que implican mecanismos redox

- Resistencia a los fármacos

- Cloroquina

- Otros enlaces

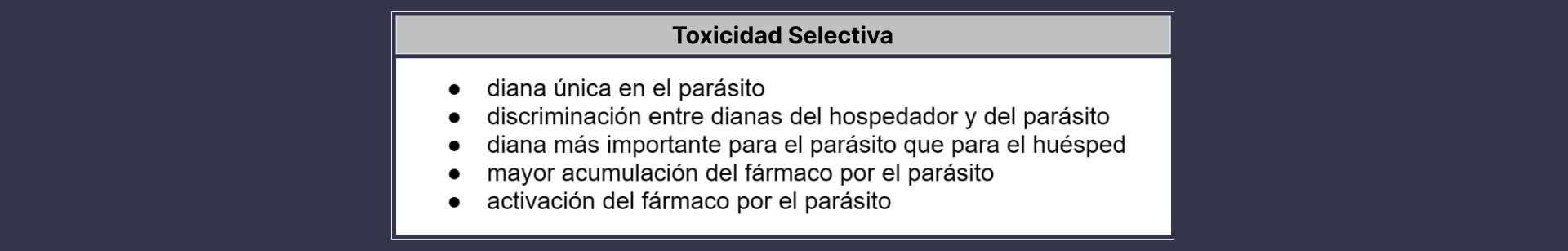

Acción de los fármacos

Los fármacos actúan interfiriendo específicamente en procesos celulares o bioquímicos, a menudo denominados "dianas". El ejemplo clásico de diana farmacológica es una enzima inhibida por el fármaco. Los fármacos eficaces mostrarán una toxicidad selectiva para el patógeno en comparación con el huésped. Muchos factores contribuyen a esta toxicidad selectiva (recuadro) y estos factores no se excluyen mutuamente. El diseño racional de fármacos trata de explotar estos diversos factores para desarrollar fármacos que sean altamente tóxicos para el patógeno y, al mismo tiempo, presenten una toxicidad mínima para el huésped.

La cloroquina y la vacuola alimentaria

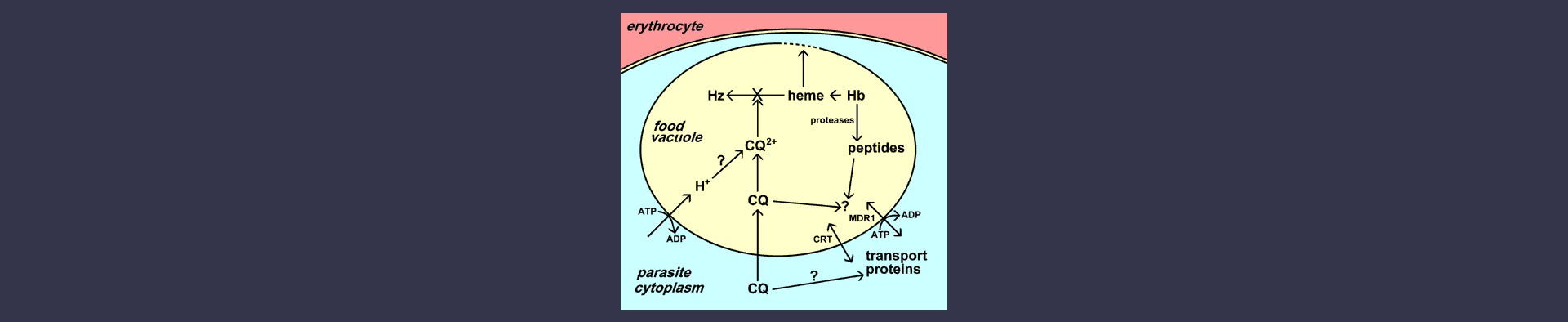

La vacuola alimentaria es un orgánulo similar al lisosoma en el que se produce la descomposición de la hemoglobina y la desintoxicación del hemo (véase un análisis más detallado de la vacuola alimentaria). La cloroquina se concentra hasta 1000 veces en la vacuola alimentaria del parásito. Los posibles mecanismos de esta acumulación selectiva de cloroquina en la vacuola alimentaria son: 1) protonación y atrapamiento iónico de la cloroquina debido al bajo pH de la vacuola alimentaria; 2) captación activa de la cloroquina por uno o varios transportadores del parásito; y/o 3) unión de la cloroquina a un receptor específico en la vacuola alimentaria.

La contribución exacta de estos tres mecanismos postulados no está clara, pero en general se acepta que la cloroquina ejerce su efecto tóxico interfiriendo en la conversión del hemo libre en hemozoína. Se liberan grandes cantidades de hemo como resultado de la digestión de la hemoglobina en la vacuola alimentaria. El hemo libre puede lisar las membranas, conducir a la generación de intermediarios reactivos del oxígeno e inhibir muchos otros procesos, por lo que es bastante tóxico. El hemo se desintoxica en la vacuola alimentaria mediante un proceso de biocristalización en el que el hemo se secuestra en grandes cristales insolubles llamados hemozoína o pigmento de la malaria. [Ver descripción más detallada de la formación de hemozoína]. Se desconoce el mecanismo exacto por el que la cloroquina inhibe la formación de hemozoína, pero la cloroquina puede unirse al hemo y esta unión puede impedir que el hemo se incorpore al cristal de hemozoína. Por lo tanto, la muerte del parásito es el resultado de la acumulación de desechos metabólicos (es decir, hemo) asociados a la digestión de la hemoglobina.

La cloroquina (CQ) se acumula en la vacuola alimentaria del parásito. Esta acumulación puede implicar el atrapamiento de iones tras la protonación, el transporte específico y/o la unión a un receptor (por ejemplo, el hemo). La principal acción de la cloroquina es inhibir la formación de hemozoína (Hz) a partir del hemo liberado por la digestión de la hemoglobina (Hb). El hemo libre lisaría entonces las membranas y provocaría la muerte del parásito. La resistencia a la cloroquina se debe a una menor acumulación de cloroquina en la vacuola alimentaria. Dos transportadores diferentes (CRT y MDR1) han sido implicados en la resistencia. Se desconocen las funciones de estos transportadores y su papel exacto en la resistencia a la cloroquina.

Otros antipalúdicos que contienen quinolina, como la mefloquina y la quinina, también parecen afectar a la vacuola alimentaria. Sin embargo, no está claro si estos fármacos se unen al hemo o afectan a la formación de hemozoína. Además, estos fármacos son bases más débiles que la coroquina y es posible que no presenten el mismo grado de captura de iones dentro de la vacuola alimentaria.